|

||||

|

|

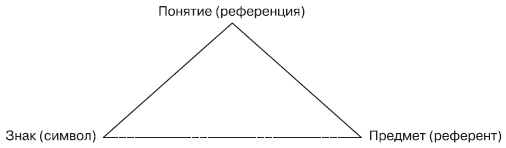

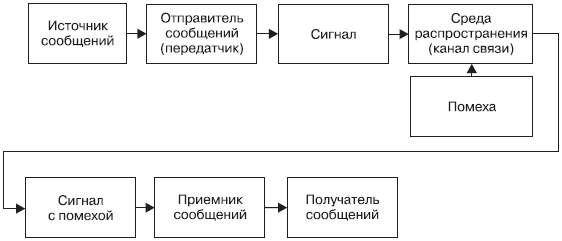

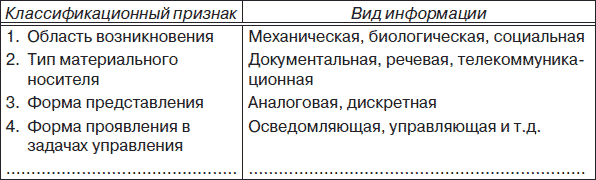

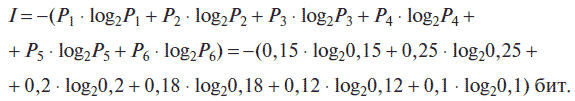

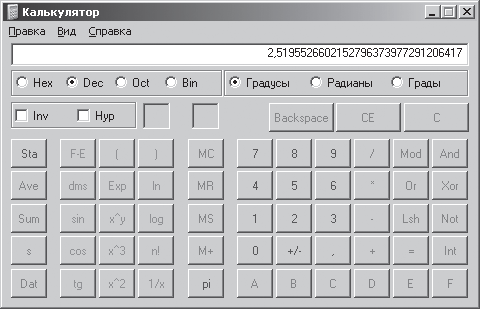

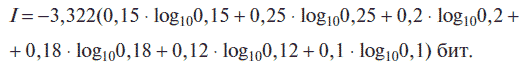

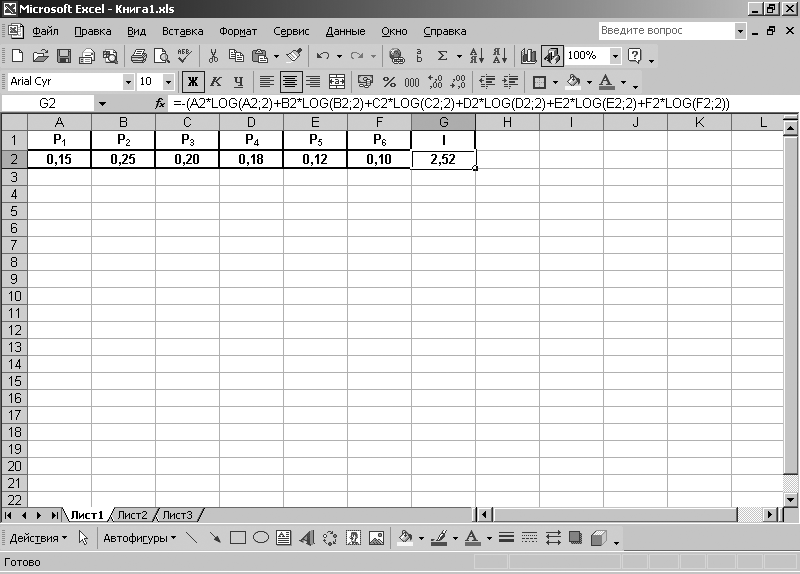

Глава 1Информация, информационные процессы и системы 1.1. Понятия информации, информационного процесса и информационной системыПонятия «информация», «информационный процесс» и «информационная система» являются основополагающими в курсе информатики, поэтому их формирование было и остается сложной проблемой, связанной в первую очередь с различными мировоззренческими подходами как отдельных авторов, так и представителей различных научных направлений и школ. Информация как научная категория – предмет изучения многих научных дисциплин: философии, информатики, физики, биологии и т. д. Информация, материя, энергия являются базовыми научными категориями, для которых не существует строгих научных определений, поэтому их заменяют соответствующими понятиями, и попытки выразить одно базовое понятие через другое нельзя считать успешными. Слово «информация» происходит от латинского слова informatio, что в переводе означает «сведение, ознакомление, разъяснение». Дословная трактовка означает то, что присуще человеческому сознанию и общению и не отражает многообразия свойств информации, которое проявляется не только на уровне общения между людьми, но и на уровне живой и неживой природы, включая и технические устройства, созданные человеком. Существует достаточно много различных определений понятия «информация», но ни одно из них не может быть принято в качестве основного, поскольку все они отражают только отдельные свойства информации, к которым можно отнести: • дуализм – свойство информации, которое характеризует ее двойственность. С одной стороны, она объективна, так как не зависит от воспринимаемого ее объекта, а с другой – субъективна, поскольку может трактоваться субъектами по-разному; • достоверность – свойство информации, которое характеризует степень соответствия информации реальному объекту с заданной точностью; • адекватность – свойство информации, которое устанавливает соответствие создаваемого с помощью информации образа реальному объекту, процессу или явлению и т. д. Этот ряд свойств информации может быть продолжен. Однако здесь наиболее важно отметить следующее: совокупность свойств информации, характеризующих степень ее соответствия потребностям пользователей, называется качеством информации [1]. При определении понятия информации целесообразно использовать подход, нашедший применение в теории информации и основанный на введении соответствующих ограничений на совокупность свойств информации, проявляющихся при взаимодействии объектов, организованных в систему. Введем общее ограничение, при котором будем рассматривать свойства информации, проявляющиеся только на уровне человеческого сознания. Если не принимать во внимание такие свойства информации, как смысловое содержание, полезность, актуальность и т. д., то при определении понятия информации можно ограничиться только вероятностным (энтропийным) уровнем рассмотрения этого понятия. (Этот уровень рассмотрения называют также синтаксическим.) На данном уровне устанавливаются внешние характеристики информации независимо от ее смыслового содержания и характера использования. При таком рассмотрении под информацией следует понимать меру устранения неопределенности в отношении интересующего нас исхода или, что то же самое, информация есть снятая неопределенность при осуществлении выбора из множества альтернатив. Если принять во внимание только свойство информации, связанное с ее смысловым содержанием, то при определении понятия информации можно ограничиться смысловым или семантическим уровнем рассмотрения этого понятия. В этом случае под информацией следует понимать меру, связывающую ее смысловое содержание со способностью человека ее осмыслить. Если принять во внимание только свойство информации, связанное с ее полезностью, то при определении понятия информации можно ограничиться прагматическим уровнем рассмотрения. В этом случае под информацией можно понимать меру достижения потребителем информации (человеком) поставленной практической цели. Таким образом, принципиально может существовать бесконечно много уровней ограничений и соответственно понятий информации. Данный вывод не содержит противоречий, поскольку учитывает одно из основных свойств информации быть всеобъемлющей. Если постулировать данное свойство, т. е. принять его как всеобщее свойство материи, связанное с отражением (материалистический подход), то можно говорить о существовании информационного поля, для которого необходимо наличие соответствующих условий. К таким условиям можно отнести наличие: а) источника информационного поля; б) среды распространения информационного поля (канала передачи); в) материальных посредников распространения информационного поля; г) приемника информационного поля. В качестве источника информационного поля могут выступать естественные природные источники, т. е. явления живой и неживой природы, и искусственные источники, созданные человеком. Наличие источника информационного поля – необходимое условие для возникновения и существования информационного поля. Среда распространения разделяется на среду с распределенными параметрами (естественные природные среды – воздушные, водные и др.) и среду с сосредоточенными параметрами (искусственные каналы передачи), созданные человеком. Наличие среды распространения информационного поля – также необходимое условие для возникновения и существования информационного поля. В качестве материальных посредников распространения информационного поля можно выделить естественных (природных) и искусственных посредников, к которым можно отнести знаки, сигналы и сообщения. Существует достаточно много определений этих понятий, однако остановимся на их трактовке исходя из представлений, выработанных семиологией – наукой, изучающей знаковые системы. Знак, или символ, можно рассматривать как некий чувственно воспринимаемый объект, который условно представляет и отсылает к обозначаемому им предмету, явлению, событию или действию. Если придерживаться этого определения, то между знаком (символом) и обозначаемым им предметом (референтом) устанавливается условная связь в виде понятия (референции) об этом предмете, которую можно представить с помощью известного треугольника Огдена и Ричардса (рис. 1.1).  Рис. 1.1. Треугольник Огдена и Ричардса Связь между знаком и предметом условна (на рис. 1.1 она показана пунктирной линией), поскольку прямой связи между ними нет. В действительности существуют знаки (символы), у которых есть понятия, но нет предмета, например некоторые знаки Зодиака (Водолей, Стрелец), мифологические персонажи (Единорог) и т. д. Сигнал можно рассматривать как материальный носитель, с помощью которого передаются характеристики информационного поля. В общем случае под сигналом следует понимать физический процесс, представленный в той или иной материально-энергетической форме (электрической, световой, звуковой и т. д.) и распространяющийся в определенной среде. Сигналу как процессу свойственны непрерывность и дискретность во времени, т. е. сигналы могут быть непрерывными или дискретными. Для передачи характеристик информационного поля сигнал как материальный носитель подвергается модуляции, т. е. определенному воздействию со стороны этихарактеристик. Кроме того, на сигнал может воздействовать и сама среда распространения сигнала в виде неблагоприятного воздействия – помехи. Свойства сигналов изучается в отдельном разделе кибернетики – теории сигналов и цепей. Сообщение можно отнести к основной характеристике информационного поля. Оно является формой представления информационного поля в виде совокупности знаков, которое передается с помощью сигналов от источника к приемнику. Сообщение как форма представления информационного поля подвергается соответствующему кодированию с помощью различных знаковых систем. Примерами сообщений могут быть телеграммы, речь, музыка, телевизионное изображение, данные на выходе вычислительных и измерительных систем и т. д. В качестве приемника информационного поля могут выступать естественные природные приемники, т. е. объекты живой и неживой природы, и искусственные приемники, созданные человеком и соответствующим образом настроенные на прием. В качестве приемника информационного поля может выступать непосредственно и сам человек. Наличие приемника информационного поля не является необходимым условием для возникновения и существования информационного поля, поскольку оно существует объективно, т. е. независимо от нас, и необязательно подлежит осмыслению. Таким образом, в общем случае коммуникативный процесс между источником и приемником сообщений можно представить в виде структурной схемы (рис. 1.2).  Рис. 1.2. Коммуникативный процесс между источником и получателем сообщений В подтверждение тому, что существует много различных понятий информации, приведем еще одно, сформулированное на основе условий существования информационного поля: информация есть свойство информационного поля, которое проявляется при обязательном выполнении всех условий его возникновения и существования. Говоря об информационном поле, необходимо также заметить, что ему присущи многообразие видов и форм представления, наличие энергетических, геометрических (пространственных), временных и другихарактеристик, а также изменение этихарактеристик под воздействием неблагоприятных факторов (помех). Многообразие видов информационного поля приводит и к многообразию видов самой информации. Для выявления определенных видов информации необходимо согласно существующим методам классификации применить тот или иной классификационный признак (критерий) для их разграничения. Таких классификационных признаков может быть достаточно много. В табл. 1.1 приведены некоторые из них и соответствующие им виды информации. Таблица 1.1 Приведенные в табл. 1.1 виды информации могут образовывать иерархические структуры, для которыхарактерно расположение видов информации в порядке от высокого уровня к низкому. Например, по области возникновения (классификационный признак первого уровня) различают: механическую (отражающую процессы и явления неживой природы), биологическую (отражающую процессы и явления живой природы) и социальную (отражающую процессы и явления в человеческом обществе). Социальную информацию в свою очередь по назначению (классификационный признак второго уровня) можно разделить натри вида: массовую, специальную и личную. Если использовать классификационный признак третьего уровня (специфика проявления), то массовый и специальный вид информации можно разделить на подвиды. Так, массовую информацию можно представить в виде общественно-политической и научно-популярной, а специальную – в виде научной, технической, экономической и управляющей [2]. Таким образом, может существовать достаточно много классификационных признаков и соответствующих им видов информации. Поскольку данное учебное пособие ориентировано в основном на студентов экономических специальностей, приведем здесь одно из определений понятия экономической информации. Экономическая информация – это информация, которая используется при осуществлении функций управления экономическими процессами, т. е. отражает и обслуживает процессы производства, распределения, обмена и потребления материальных благ. Экономическая информация служит основой для осуществления управления процессами в области экономики и обладает рядом характерных свойств: многоцелевым назначением, цикличностью, простотой математических операций, сложностью логических процедур и т. д. [2]. С понятием «информация» тесно связаны такие понятия, как «информационный процесс» и «информационная система». Это также достаточно сложные нормы, трактовка которых далеко не однозначна. Под информационным процессом в данном случае будем понимать последовательность действий, выполняемых с информацией. К таким действиям можно отнести отбор (восприятие), преобразование, передачу, обработку, хранение и поиск информации. Кратко охарактеризуем каждое из этих действий (более подробное их описание можно найти в соответствующей литературе [1,3]). Отбор информации связан с целенаправленным извлечением и анализом информации об объекте, процессе или явлении. Результатом этого отбора являются формирование модели (образа) объекта, процесса или явления, их опознание и оценка. Отбор информации выполняет несколько функций, среди которых можно выделить две важных функции: оценка информации на значимость и сжатие информации [3]. При оценке информации на значимость происходит ее селекция, или информационная фильтрация, результатом которой является отделение полезной информации от информационных шумов (помех). Сжатие информации необходимо для ее представления в компактном виде, позволяющем более эффективно использовать каналы, по которым передается информация, и средства ее хранения. Преобразование информации включает в себя операции, связанные с нормализацией (приведение к определенным нормам), аналого-цифровым преобразованием, кодированием и т. д. Результатом преобразования информации является материальный носитель (сигнал), представленный в форме, удобной для передачи, обработки и хранения. Передача информации – важная составляющая информационного процесса, в результате которого происходит транспортировка информации от источника информации к приемнику. Передача осуществляется в среде распространения по соответствующим каналам, имеющим различную физическую природу: электромагнитную, электрическую, оптическую и т. д. Обработка информации также является важной составляющей информационного процесса. Под обработкой информации можно понимать действия, производимые с информацией по определенным законам (математики, логики, физики и т. д.) и неформальным правилам (опыт, интуиция, здравый смысл и т. д.). Результатом обработки является тоже информация, которая может быть представлена в иных формах (например, упорядоченная по каким-то признакам) или содержать ответы на поставленные вопросы [1]. В случае если процесс обработки подлежит формализации, он может осуществляться техническими средствами, например обработка информации на компьютере. Хранение информации связано с ее записью на некоторый материальный носитель с целью дальнейшего поиска, извлечения и использования. В качестве таких носителей могут использоваться бумага, магнитная лента, накопители на гибких и жестких магнитных дисках, на оптических и магнитооптических дисках и т. д. В заключение, говоря об информационном процессе, необходимо отметить, что это не простая последовательность действий, выполняемых с информацией, а их сложная взаимосвязь, взаимопроникновение и развитие. В каждом действии (составляющем процесс информации) можно найти признаки других составляющих: в отборе – преобразование, в хранении – передачу, в передаче – обработку и т. д. Реализуются информационные процессы в системах, которые называются информационными, при этом под системой в общем случае понимается совокупность объектов и отношений между ними, существующая как единое целое. Информационные системы также можно классифицировать по различным признакам: по сфере применения, организации информационных процессов, территориальному признаку, степени автоматизации информационных процессов и т. д. Например, по сфере применения информационные системы можно подразделить на административные, экономические, производственные, медицинские и т. д. Для экономической информационной системы характерными признаками являются: непрерывное развитие, обусловленное появлением новых потребностей, сменой механизма хозяйствования; многоцелевой характер функционирования; присутствие человека как основного элемента системы. Под экономической информационной системой (ЭИС) будем понимать совокупность внутренних и внешних потоков прямой и обратной информационной связи экономического объекта, методов, средств, специалистов, участвующих в процессе обработки информации и выработке управленческих решений [2]. В качестве примера можно привести финансовые, банковские, страховые и тому пободные ЭИС. 1.2. Определение количества информации. Единицы измерения количества информацииКак уже отмечалось, понятие информации можно рассматривать при различных ограничениях, накладываемых на ее свойства, т. е. при различных уровнях рассмотрения. В основном выделяют три уровня – синтаксический, семантический и прагматический. Соответственно на каждом из них для определения количества информации применяют различные оценки. На синтаксическом уровне для оценки количества информации используют вероятностные методы, которые принимают во внимание только вероятностные свойства информации и не учитывают другие (смысловое содержание, полезность, актуальность и т. д.). Разработанные в середине XX в. математические и, в частности, вероятностные методы позволили сформировать подход к оценке количества информации как к мере уменьшения неопределенности знаний. Такой подход, называемый также вероятностным, постулирует принцип: если некоторое сообщение приводит к уменьшению неопределенности наших знаний, то можно утверждать, что такое сообщение содержит информацию. При этом сообщения содержат информацию о каких-либо событиях, которые могут реализоваться с различными вероятностями. Формулу для определения количества информации для событий с различными вероятностями и получаемых от дискретного источника информации предложил американский ученый К. Шеннон в 1948 г. Согласно этой формуле количество информации может быть определено следующим образом:  где I – количество информации; N – количество возможных событий (сообщений); pi – вероятность отдельных событий (сообщений); ? – математический знак суммы чисел. Определяемое с помощью формулы (1.1) количество информации принимает только положительное значение. Поскольку вероятность отдельных событий меньше единицы, то соответственно выражение log^,– является отрицательной величиной и для получения положительного значения количества информации в формуле (1.1) перед знаком суммы стоит знак минус. Если вероятность появления отдельных событий одинаковая и они образуют полную группу событий, т. е.  то формула (1.1) преобразуется в формулу Р. Хартли:  В формулах (1.1) и (1.2) отношение между количеством информации и соответственно вероятностью, или количеством, отдельных событий выражается с помощью логарифма. Применение логарифмов в формулах (1.1) и (1.2) можно объяснить следующим образом. Для простоты рассуждений воспользуемся соотношением (1.2). Будем последовательно присваивать аргументу N значения, выбираемые, например, из ряда чисел: 1, 2, 4, 8, 16, 32, 64 и т. д. Чтобы определить, какое событие из N равновероятных событий произошло, для каждого числа ряда необходимо последовательно производить операции выбора из двух возможных событий. Так, при N = 1 количество операций будет равно 0 (вероятность события равна 1), при N = 2, количество операций будет равно 1, при N = 4 количество операций будет равно 2, при N = 8, количество операций будет равно 3 и т. д. Таким образом получим следующий ряд чисел: 0, 1, 2, 3, 4, 5, 6 и т. д., который можно считать соответствующим значениям функции I в соотношении (1.2). Последовательность значений чисел, которые принимает аргумент N, представляет собой ряд, известный в математике как ряд чисел, образующих геометрическую прогрессию, а последовательность значений чисел, которые принимает функция I, будет являться рядом, образующим арифметическую прогрессию. Таким образом, логарифм в формулах (1.1) и (1.2) устанавливает соотношение между рядами, представляющими геометрическую и арифметическую прогрессии, что достаточно хорошо известно в математике. Для количественного определения (оценки) любой физической величины необходимо определить единицу измерения, которая в теории измерений носит название меры. Как уже отмечалось, информацию перед обработкой, передачей и хранением необходимо подвергнуть кодированию. Кодирование производится с помощью специальных алфавитов (знаковых систем). В информатике, изучающей процессы получения, обработки, передачи и хранения информации с помощью вычислительных (компьютерных) систем, в основном используется двоичное кодирование, при котором используется знаковая система, состоящая из двух символов 0 и 1. По этой причине в формулах (1.1) и (1.2) в качестве основания логарифма используется цифра 2. Исходя из вероятностного подхода к определению количества информации эти два символа двоичной знаковой системы можно рассматривать как два различных возможных события, поэтому за единицу количества информации принято такое количество информации, которое содержит сообщение, уменьшающее неопределенность знания в два раза (до получения событий их вероятность равна 0,5, после получения – 1, неопределенность уменьшается соответственно: 1/0,5 = 2, т. е. в 2 раза). Такая единица измерения информации называется битом (от англ. слова binary digit – двоичная цифра). Таким образом, в качестве меры для оценки количества информации на синтаксическом уровне, при условии двоичного кодирования, принят один бит. Следующей по величине единицей измерения количества информации является байт, представляющий собой последовательность, составленную из восьми бит, т. е. 1 байт = 23 бит = 8 бит. В информатике также широко используются кратные байту единицы измерения количества информации, однако в отличие от метрической системы мер, где в качестве множителей кратных единиц применяют коэффициент 10n, где п = 3, 6, 9 и т. д., в кратных единицах измерения количества информации используется коэффициент 2n. Выбор этот объясняется тем, что компьютер в основном оперирует числами не в десятичной, а в двоичной системе счисления. Кратные байту единицы измерения количества информации вводятся следующим образом: 1 Килобайт (Кбайт) = 210 байт = 1024 байт, 1 Мегабайт (Мбайт) = 210 Кбайт = 1024 Кбайт, 1 Гигабайт (Гбайт) = 210 Мбайт = 1024 Мбайт, 1 Терабайт (Тбайт) = 210 Гбайт = 1024 Гбайт, 1 Петабайт (Пбайт) = 210 Тбайт = 1024 Тбайт, 1 Экзабайт (Эбайт) = 210 Пбайт = 1024 Пбайт. Единицы измерения количества информации, в названии которых есть приставки «кило», «мега» и т. д., с точки зрения теории измерений не являются корректными, поскольку эти приставки используются в метрической системе мер, в которой в качестве множителей кратных единиц используется коэффициент 10n, где п = 3, 6, 9 и т. д. Для устранения этой некорректности международная организацией International Electrotechnical Commission, занимающаяся созданием стандартов для отрасли электронных технологий, утвердила ряд новых приставок для единиц измерения количества информации: киби (kibi), меби (mebi), гиби (gibi), теби (tebi), пети (peti), эксби (exbi). Однако пока используются старые обозначения единиц измерения количества информации, и требуется время, чтобы новые названия начали широко применяться. Вероятностный подход используется и при определении количества информации, представленной с помощью знаковых систем. Если рассматривать символы алфавита как множество возможных сообщений N, то количество информации, которое несет один знак алфавита, можно определить по формуле (1.1). При равновероятном появлении каждого знака алфавита в тексте сообщения для определения количества информации можно воспользоваться формулой (1.2). Количество информации, которое несет один знак алфавита, тем больше, чем больше знаков входит в этот алфавит. Количество знаков, входящих в алфавит, называется мощностью алфавита. Количество информации (информационный объем), содержащееся в сообщении, закодированном с помощью знаковой системы и содержащем определенное количество знаков (символов), определяется с помощью формулы:  где V – информационный объем сообщения; / = log2N, информационный объем одного символа (знака); К – количество символов (знаков) в сообщении; N – мощность алфавита (количество знаков в алфавите). Поясним вышесказанное в п. 1.2 на примерах. Пример 1.1Определим, какое количество информации можно получить после реализации одного из шести событий. Вероятность первого события составляет 0,15; второго – 0,25; третьего – 0,2; четвертого – 0,12; пятого – 0,12; шестого – 0,1, т. е. Р1 = 0,15; Р2 = 0,25; Р3 = 0,2; Р4 = 0,18; Р5 = 0,12; Р6 = 0,1. Решение. Для определения количества информации применим формулу (1.1)  Для вычисления этого выражения, содержащего логарифмы, воспользуемся сначала компьютерным калькулятором, а затем табличным процессором Microsoft (MS) Excel, входящим в интегрированный пакет программ MS Office ХР. Для вычисления с помощью компьютерного калькулятора выполним следующие действия. С помощью команды: [Кнопка Пуск – Программы – Стандартные – Калькулятор] запустим программу Калькулятор. После запуска программы выполним команду: [Вид – Инженерный] (рис. 1.3).  Рис. 1.3. Инженерный калькулятор Кнопка log калькулятора производит вычисление десятичного (по основанию 10) логарифма отображаемого числа. Поскольку в нашем случае необходимо производить вычисления логарифмов по основанию 2, а данный калькулятор не позволяет этого делать, то необходимо воспользоваться известной формулой: logbN = М · logaN, где  В нашем случае соотношение примет вид: log2N = M log10N, где  т. е log2N = 3,322 · log10N, и выражение для вычисления количества информации примет вид:  При вычислении на калькуляторе используем кнопки: +/- (изменение знака отображаемого числа),() (открывающие и закрывающие скобки), log (логарифм числа по основанию 10) и т. д. Результат вычисления показан на рис. 1.3. Таким образом, количество информации I = 2,52 бит. Воспользуемся теперь табличным процессором MS Excel. Для запуска программы Excel выполним команду: [Кнопка Пуск – Программы – MS Office ХР – Microsoft Excel]. В ячейки А1, В1, С1, D1, E1, F1 открывшегося окна Excel запишем буквенные обозначения вероятностей Р1, Р2, P3, Р4, P5, P6 а в ячейку G1 – количество информации I, которое необходимо определить. Для написания нижних индексов у вероятностей Р1 ? P6 в ячейках А1, В1, С1, D1, E1, F1 выполним следующую команду: [Формат – Ячейки – Шрифт – Видоизменение (поставим флажок напротив нижнего индекса) ]. В ячейки А2, В2, С2, D2, Е2, F2 запишем соответствующие значения вероятностей. После записи значений в ячейки необходимо установить в них формат числа. Для этого необходимо выполнить следующую команду: [Формат – Ячейки – Число – Числовой (устанавливаем число десятичных знаков, равное двум) ]. Устанавливаем в ячейке G2 тот же числовой формат. В ячейку G2 записываем выражение = – (A2*LOG(A2;2) + B2*LOG(B2;2) + C2*LOG(C2;2) + D2*LOG(D2;2) + E2*LOG(E2;2) + F2*LOG(F2;2) ). После нажатия на клавиатуре компьютера клавиши <Enter>, в ячейке G2 получим искомый результат – I = 2,52 бит (рис. 1.4).  Рис. 1.4. Результат вычисления количества информации Пример 1.2 Определим, какое количество байт и бит информации содержится в сообщении, если его объем составляет 0,25 Кбайта. Решение. С помощью калькулятора определим количество байт и бит информации, которое содержится в данном сообщении: I = 0,25 Кбайт · 1024 байт/1 Кбайт = 256 байт; I = 256 байт · 8 бит/1 байт = 2048 бит. Пример 1.3 Определим мощность алфавита, с помощью которого передано сообщение, содержащее 4096 символов, если информационный объем сообщения составляет 2 Кбайта. Решение. С помощью калькулятора переведем информационный объем сообщения из килобайт в биты: V = 2 Кбайт 1024 байт/1 Кбайт = 2048 байт 8 бит/1 байт = 16384 бит. Определим количество бит, приходящееся на один символ (информационный объем одного символа) в алфавите: I = 16 384 бит/4096 = 4 бит. Используя формулу (1.3), определим мощность алфавита (количество символов в алфавите) : N = 2I = 24 = 16. Как уже отмечалось, если принять во внимание только свойство информации, связанное с ее смысловым содержанием, то при определении понятия информации можно ограничиться смысловым, или семантическим, уровнем рассмотрения этого понятия. На семантическом уровне информация рассматривается по ее содержанию, отражающему состояние отдельного объекта или системы в целом. При этом не учитывается ее полезность для получателя информации. На данном уровне изучаются отношения между знаками, их предметными и смысловыми значениями (см. рис. 1.1), что позволяет осуществить выбор смысловых единиц измерения информации. Поскольку смысловое содержание информации передается с помощью сообщения, т. е. в виде совокупности знаков (символов), передаваемых с помощью сигналов от источника информации к приемнику, то широкое распространение для измерения смыслового содержания информации получил подход, основанный на использовании тезаурусной меры. При этом под тезаурусом понимается совокупность априорной информации (сведений), которой располагает приемник информации. Данный подход предполагает, что для понимания (осмысливания) и использования полученной информации приемник (получатель) должен обладать априорной информацией (тезаурусом), т. е. определенным запасом знаков, наполненных смыслом, слов, понятий, названий явлений и объектов, между которыми установлены связи на смысловом уровне. Таким образом, если принять знания о данном объекте или явлении за тезаурус, то количество информации, содержащееся в новом сообщении о данном предмете, можно оценить по изменению индивидуального тезауруса под воздействием данного сообщения. В зависимости от соотношений между смысловым содержанием сообщения и тезаурусом пользователя изменяется количество семантической информации, при этом характер такой зависимости не поддается строгому математическому описанию и сводится к рассмотрению трех основных условий, при которых тезаурус пользователя: • стремится к нулю, т. е. пользователь не воспринимает поступившее сообщение; • стремится к бесконечности, т. е. пользователь досконально знает все об объекте или явлении и поступившее сообщение его не интересует; • согласован со смысловым содержанием сообщения, т. е. поступившее сообщение понятно пользователю и несет новые сведения. Два первых предельных случая соответствуют состоянию, при котором количество семантической информации, получаемое пользователем, минимально. Третий случай связан с получением максимального количества семантической информации. Таким образом, количество семантической информации, получаемой пользователем, является величиной относительной, поскольку одно и то же сообщение может иметь смысловое содержание для компетентного и быть бессмысленным для некомпетентного пользователя. Поэтому возникает сложность получения объективной оценки количества информации на семантическом уровне ее рассмотрения и для получения такой оценки используют различные единицы измерения количества информации: абсолютные или относительные. В качестве абсолютных единиц измерения могут использоваться символы, реквизиты, записи и т. д., а в качестве относительной – коэффициент содержательности, который определяется как отношение семантической информации к ее объему. Например, для определения на семантическом уровне количества информации, полученной студентами на занятиях, в качестве единицы измерения может быть принят исходный балл (символ), характеризующий степень усвояемости ими нового учебного материала, на основе которого можно косвенно определить количество информации, полученное каждым студентом. Это количество информации будет выражено через соответствующий оценочный балл в принятом диапазоне оценок. При семантическом подходе к оценке количества информации и выборе единицы измерения существенным является вид получаемой информации (сообщения). Так, данный подход к оценке количества экономической информации позволяет выявить составную единицу экономической информации, состоящую из совокупности других единиц информации, связанных между собой по смыслу. Элементарной составляющей единицей экономической информации является реквизит, т. е. информационная совокупность, которая не поддается дальнейшему делению на единицы информации на смысловом уровне. Деление реквизитов на символы приводит к потере их смыслового содержания. Каждый реквизит характеризуется именем, значением и типом. При этом под именем реквизита понимается его условное обозначение, под значением – величина, характеризующая свойства объекта или явления в определенных обстоятельствах, под типом – множество значений реквизита, объединенных определенными признаками и совокупностью допустимых преобразований. Реквизиты принято делить на реквизиты-основания и реквизиты-признаки [2]. Реквизиты-основания характеризуют количественную сторону экономического объекта, процесса или явления, которые могут быть получены в результате совершения отдельных операций – вычислений, измерений, подсчета натуральных единиц и т. д. В экономических документах к ним можно отнести, например, цену товара, его количество, сумму и т. п. Реквизиты-основания чаще всего выражаются в цифрах, над которыми могут выполняться математические операции. Реквизиты-признаки отражают качественные свойства экономического объекта, процесса или явления. С помощью реквизитов-признаков сообщения приобретают индивидуальный характер. В экономических документах к ним можно отнести, например, номер документа, имя отправителя, дату составления документа, вид операции и т. п. Реквизиты-признаки позволяют осуществлять логическую обработку единиц количества информации на семантическом уровне: поиск, выборку, группировку, сортировку и т. д. Отдельный реквизит-основание вместе с относящимися к нему реквизитами-признаками образует следующую в иерархическом отношении составную единицу экономической информации – показатель. Показатель имеет наименование, в состав которого входят термины, обозначающие измеряемый объект: себестоимость, затраты, мощность, прибыль и т. д. Кроме того, показатель содержит формальную характеристику и дополнительные признаки. К формальной характеристике относится способ его получения (объем, сумма, прирост, процент, среднее значение и т. д.), а к дополнительным – пространственно-временные (где находится измеряемый объект, время, к которому относится данный показатель) и метрологические (единицы измерения). Таким образом, с помощью совокупности реквизитов и соответствующих им показателей можно оценить количество экономической информации, получаемой от исследуемого объекта (источника информации). Кроме подхода, основанного на использовании тезаурусной меры, при определении количества информации на семантическом уровне находят применение и другие подходы [1]. Например, один из подходов, связанных с семантической оценкой количества информации, заключается в том, что в качестве основного критерия семантической ценности информации, содержащейся в сообщении, принимается количество ссылок на него в других сообщениях. Количество получаемой информации определяется на основе статистической обработки ссылок в различных выборках. Подводя итог сказанному, можно утверждать, что существовала и существует проблема формирования единого системного подхода к определению информации на семантическом уровне. Это подтверждается и тем, что в свое время для создания строгой научной теории информации К. Шеннон вынужден был отбросить важное свойство информации, связанное со смысловым ее содержанием. Кроме перечисленных уровней рассмотрения понятия информации достаточно широко используется прагматический уровень. На данном уровне информация рассматривается с точки зрения ее полезности (ценности) для достижения потребителем информации (человеком) поставленной практической цели. Данный подход при определении полезности информации основан на расчете приращения вероятности достижения цели до и после получения получения информации [1]. Количество информации, определяющее ее ценность (полезность), находится по формуле:  где Р0, P1 – вероятность достижения цели соответственно до и после получения информации. В качестве единицы измерения (меры) количества информации, определяющей ее ценность, может быть принят 1 бит (при основании логарифма, равном 2), т. е. это такое количество полученной информации, при котором отношение вероятностей достижения цели равно 2. Рассмотрим три случая, когда количество информации, определяющее ее ценность, равно нулю и когда она принимает положительное и отрицательное значение. Количество информации равно нулю при Р0 = Р1, т.е. полученная информация не увеличивает и не уменьшает вероятность достижения цели. Значение информации является положительной величиной при P1 > P0, т. е. полученная информация уменьшает исходную неопределенность и увеличивает вероятность достижения цели. Значение информации является отрицательной величиной при P1 < P0, т. е. полученная информация увеличивает исходную неопределенность и уменьшает вероятность достижения цели. Такую информацию называют дезинформацией. Дальнейшее развитие данного подхода базируется на статистической теории информации и теории решений. При этом кроме вероятностныхарактеристик достижения цели после получения информации вводятся функции потерь и оценка полезности информации производится в результате минимизации функции потерь. Максимальной ценностью обладает то количество информации, которое уменьшает потери до нуля при достижении поставленной цели [1]. Упражнения для самостоятельного выполнения1. Преобразовать формулу (1.1) к виду (1.2) для частного случая, когда события равновероятны (pi = 1/N). 2. Доказать, что количество информации, которое мы получаем, достигает максимального значения, если события равновероятны. 3. По каналу связи передается пять сообщений, вероятность получения первого сообщения составляет 0,3; второго – 0,2; третьего – 0,14, а вероятности получения четвертого и пятого сообщений равны между собой. Какое количество информации мы получим после приема одного из сообщений?  4. Совершаются два события. При каких вероятностях этих событий мы получим минимальное и максимальное количество информации? 5. Какое количество информации несет в себе сообщение о том, что нужная вам компьютерная программа находится на одной из семи дискет? 6. С помощью компьютерного калькулятора заполнить пропуски числами: а) 2 Кбайт = ___ байт = ___ бит; б) ___ Гбайт = 2357 Мбайт = ___ Кбайт; в) ___ Кбайт = ___ байт = 14567 бит; г) 3 Гбайт = __ Мбайт = ___ Кбайт; д) ___ Тбайт = 8 Гбайт = ___ Мбайт. 7. Используя программу Excel реализовать таблицы для автоматического расчета пропущенных значений, указанных в упражнении 6. 8. Определить информационную емкость буквы в русском и латинском алфавитах. 9. Сколько символов содержит сообщение, если его информационный объем составляет 1,25 Кбайта и мощность алфавита, с помощью которого записано сообщение, равна 32? 10. Опытный пользователь компьютера может вводить в минуту 110 знаков. Мощность алфавита, используемого в компьютере, равна 256. Какое количество информации в байтах может ввести пользователь в компьютер за 1 и 1,5 минуты? 11. Установить качественную зависимость между мощностью алфавита, сообщением, составленным из символов алфавита, и его информационным объемом. 12. Определить количество информации, определяющее ее ценность, если вероятность достижения цели до получения информации равна 0,5, а после получения информации – 0,3. |

|

||

|

Главная | В избранное | Наш E-MAIL | Добавить материал | Нашёл ошибку | Вверх |

||||

|

|

||||